A Royal Road to Machine Learning

Machine Learning es el motor que ha transformado industrias enteras a lo largo de todo el planeta, durante los últimos 30 años se ha convertido en una componente esencial para el crecimiento de las compañías por medio de la automatización y en el mejor de los casos la Inteligencia Artificial.

En Hispanoamérica hemos sentido este sismo y afortunadamente cada vez es mayor el interés por implementar soluciones mediante algoritmos de Machine Learning.

Este artículo está dedicado a sugerir las ideas generales de un Royal Road a Machine Learning a través de cinco importantes teoremas matemáticos, a saber:

- Teorema de Gauss-Markov

- Teorema de Fubini

- Primer teorema de Shannon

- El teorema de representación de Wold

- Teorema Gradiente de Política

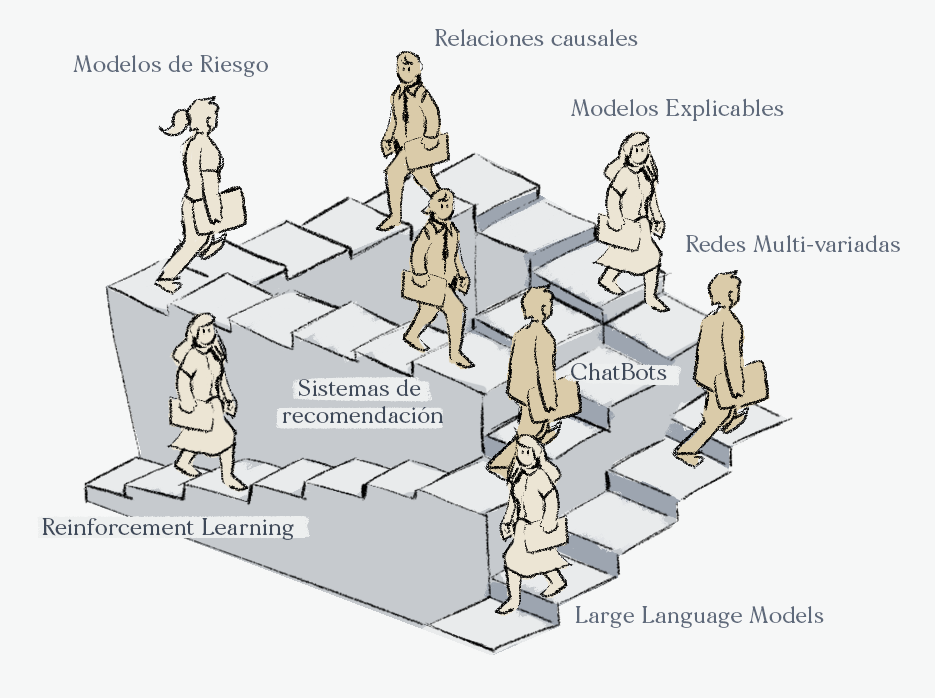

Estos temas están relacionados con los siguientes temas los cuales desde nuestro punto de vista son indispensables para la comprensión cabal de Machine Learning:

- Modelos supervisados lineales y ruido estocástico

- Variables latentes y Procesamiento del Lenguaje Natural

- Compresión de poblaciones y entropía

- Datos temporales y modelos auto-regresivos

- Importancia del método del gradiente y aprendizaje por refuerzo

¿Royal Road?

Euclides es uno de los matemáticos más importantes de todos los tiempos sus libros Los Elementos es el primer desarrollo axiomático de una teoría matemática. Comenzando con 5 postulados simples sobre la geometría y nociones comunes, documentó todas las deducciones lógicas necesarias para escribir todos los teoremas hasta ese momento conocidos sobre la geometría plana y en 3 dimensiones. Por supuesto que el nombre de geometría euclidiana hace referencia a él.

En una célebre anécdota se cuenta que un rey le pidió a Euclides una sugerencia para entender sus libros en poco tiempo, entonces Euclides le respondió que no existía un camino real para comprender la geometría y debía tomarse el tiempo para leer su trabajo completo.

Evidentemente en el Colegio de Matemáticas Bourbaki tampoco sugerimos un camino fast-track para aprender Machine Learning, a lo que le llamamos un Royal Road to Machine Learning es al proceso de aprendizaje en el cual los estudiantes van a dedicarle tiempo a la comprensión de las ideas matemáticas detrás de las aplicaciones de estos modelos.

Teorema de Gauss-Markov

Una de las primeras preguntas que nos podríamos hacer al implementar modelos supervisados en Machine Learning es por qué los errores se calculan utilizando el cuadrado de las diferencias entre las predicciones y las etiquetas de nuestro conjunto de entrenamiento.

El teorema de Gauss-Markov garantiza que esta métrica es la adecuada durante el proceso de entrenamiento para los modelos supervisados en los que se cumplan las hipótesis mínimas sobre los errores de un modelo lineal sin algún sesgo.

En nuestro curso Matemáticas para Ciencia de Datos podrán aprender las importantes implicaciones que tiene este teorema.

Teorema de Fubini

El teorema de Fubini explica la relación que existe entre dos propiedades probabilistas que podrían satisfacer las columnas de una base de datos, a saber la intercambiabilidad y la independencia estadística. En NLP este teorema es indispensable para entender algunos de los modelos de Topic Modeling más utilizados como LDA.

Este teorema garantiza que a pesar de que la intercambiabilidad parece una hipótesis menos restrictiva que la independencia, en presencia de algún conjunto de variables latentes relacionadas con nuestros datos iniciales, ambas hipótesis son equivalentes.

En nuestro curso Machine Learning & AI for the Working Analyst podrán aprender las importantes implicaciones que tiene este teorema.

Primer teorema de Shannon

La transmisión de la información por medio de un muestreo es el problema principal detrás de todos los enfoques data-driven, ¿es posible extraer conclusiones definitivas sobre un fenómeno cuando solo tenemos acceso a una población parcial?

La primera persona en estudiar matemáticamente la comunicación de información mediante muestreos aleatorios fue el genial Claude Shannon quien utilizó en se célebre segundo teorema de codificación de fuentes para acotar por debajo la cantidad de información muestreada.

En nuestro curso Matemáticas para Ciencia de Datos podrán aprender las importantes implicaciones que tiene este teorema.

El teorema de representación de Wold

El modelado de los procesos temporales como los precios de las acciones o las ventas dentro de una compañía, representan un reto mayúsculo para los científicos de datos pues en el peor de los escenarios no se cuenta con características extras que puedan utilizarse para realizar predicciones.

El teorema de representación de Wold garantiza que las series temporales cuando satisfacen una hipótesis de estacionaridad pueden descomponerse en dos componentes, una de ellas determinista y la otra aleatoria. Una de ellas utiliza información histórica de la misma fuente de datos y la otra afortunadamente no es temporal lo cual permite un modelado más sencillo.

En nuestro curso Machine Learning & AI for the Working Analyst podrán aprender las importantes implicaciones que tiene este teorema.

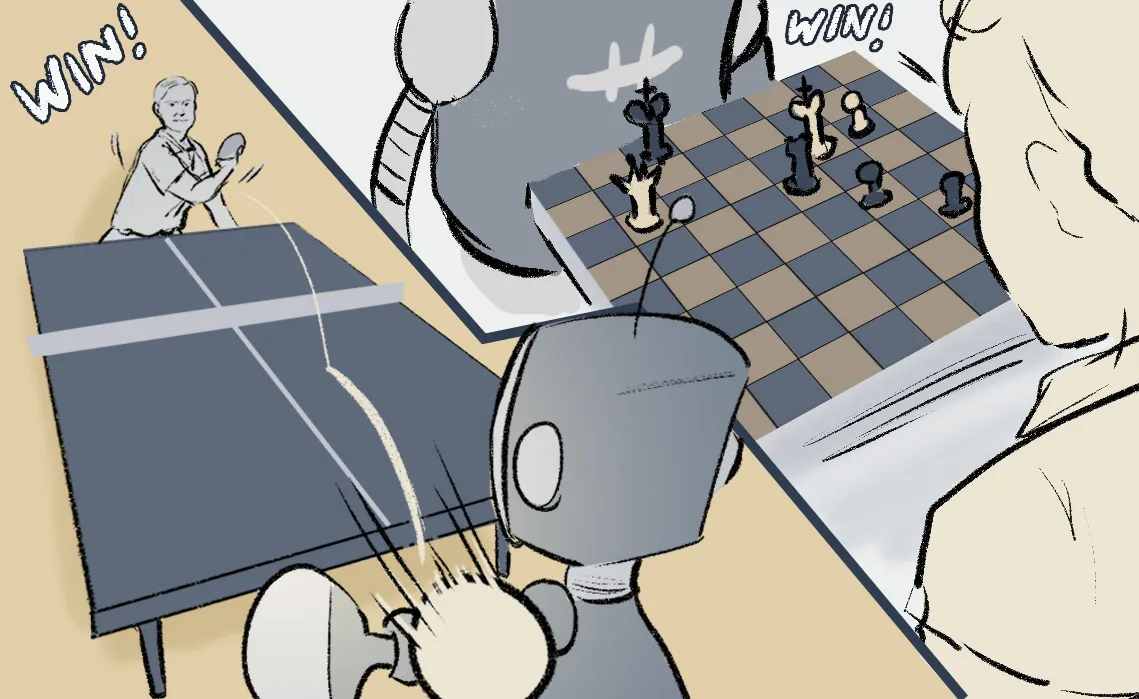

Teorema del Gradiente de la Política

El aprendizaje por refuerzo en palabras de Yann LeCun es la cereza del pastel de Machine Learning y posiblemente una de las herramientas más exitosas para generar políticas consideradas como Inteligencia Artificial. Existen distintos métodos para entrenar los modelos de Markov que se utilizan en aprendizaje por refuerzo y el teorema del Gradiente de la Política explican la relación entre algunos de los métodos de entrenamiento más comúnes.

En nuestro curso Especialización en Deep Learning podrán aprender las importantes implicaciones que tiene este teorema.

Oferta académica

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

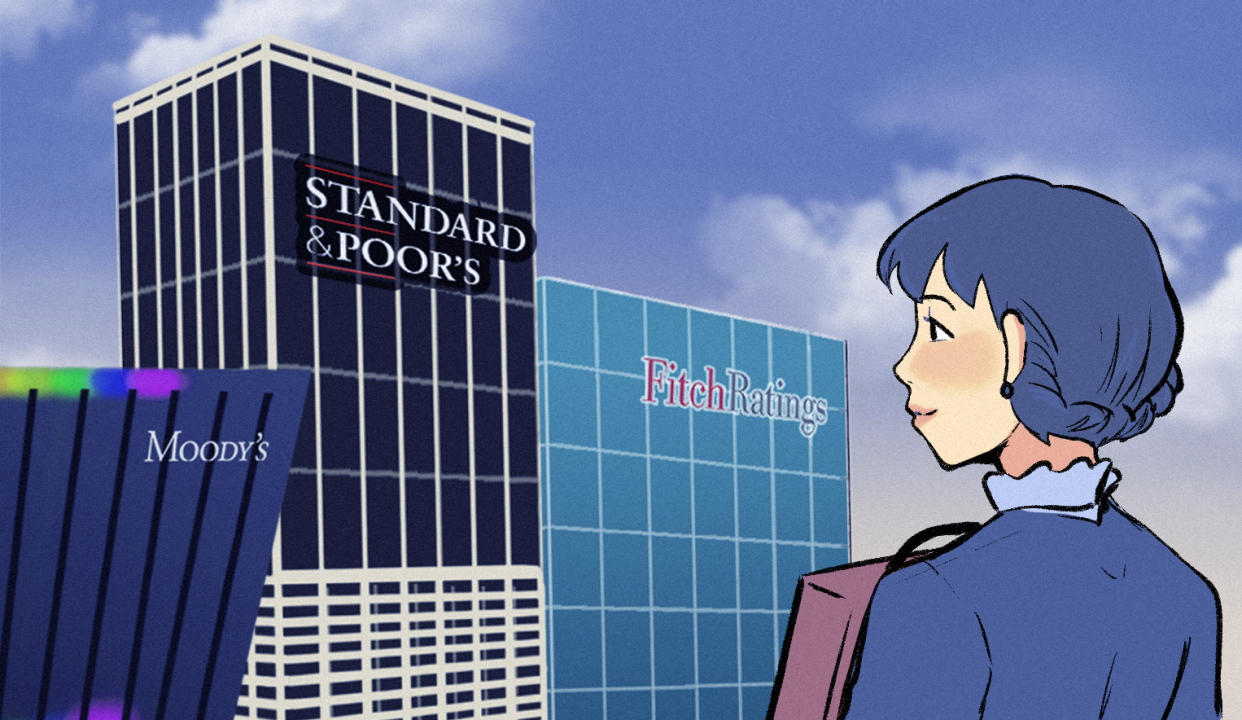

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).