The unreasonable effectiveness of data science

La inteligencia artificial ha cautivado nuestro interés desde 1940 cuando Alan Turing ayudó a vencer a los nazis por medio de una de las primeras computadoras de la historia.

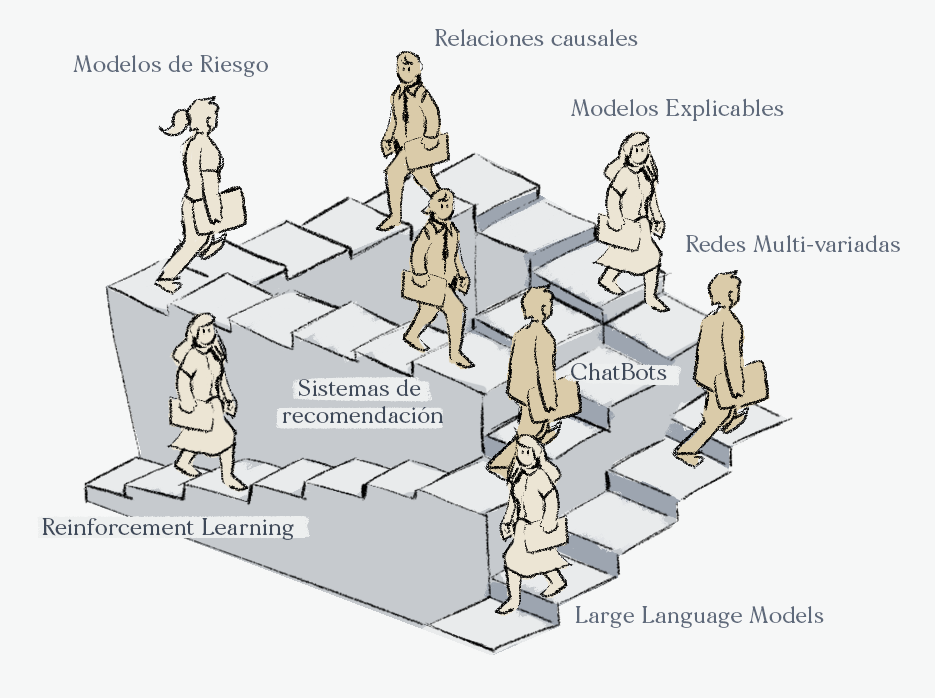

En nuestro curso propedéutico para los alumnos del Colegio de Matemáticas Bourbaki hemos identificado 10 hitos que han transformado industrias, ganado guerras y adelantado décadas la investigación científica:

- Descifrando enigma (1940)

- Cybernetcs (1950)

- ELIZA y los Chatbots(1964)

- MYCIN y los sistemas expertos (1970)

- Reyes Bayesianas (1985)

- ImageNET y Deep Learning(1995)

- Page Rank y Google (1996)

- DeepBlue v.s Kasparov(1997)

- AlphaFold (2020)

- ChatGPT(2022)

En este texto argumentaremos cómo estos hitos dependen fuertemente del desarrollo de buenas prácticas y avances en la Ciencia de Datos. Hemos elegido los siguientes ejemplos no exhaustivos:

- Escalas correctas: Ley de Zipf

- Lenguajes de programación eficientes: Pytorch Lightning

- Métricas flexibles: Plegamiento de proteínas

Para hablar de estos temas vamos a hacer un pequeño recuento de la génesis de estos métodos no en sofisticados científicos sino en profesionales con un énfasis empírico sobre el muy teórico.

Escalas correctas la lingüística

El lingüista estadounidense George Kingsley Zipf observó (quizás no por primera vez) que existe una relación inversamente proporcional entre el ranking de una palabra adentro de un texto de acuerdo a su frecuencia y la frecuencia de esa palabra.

Representar a las variables de un conjunto de datos en su escala correcta es indispensable para la preparación de un modelo de machine learning, recordemos que lo que los modelos ven solo solo vectores y mientras más contexto podamos agregar en el pre-procesamiento, más ayudaremos a estos algoritmos.

Esta relación es utilizada en el Procesamiento del Lenguaje Natural y aunque no es parte del desarrollo de los Grandes Modelos de Lenguaje, sí es una buena práctica para modelos de NLP menos sofisticados. En nuestros cursos de NLP por ejemplo con Ana Isabel Ascencio Pedraza enseñamos con detalle estos métodos.

Lenguajes de programación eficientes y Lightning AI

Bien entendidas redes neuronales profundas son un Frankenstein de distintas componentes que se deben de juntar armoniosamente para generar buenos resultados.

Desde un punto de vista de quien implemente estas arquitecturas, la flexibilidad para mover las distintas componentes de una manera muy visual es fundamental. Bibliotecas como Pytorch son muy utilizadas debido a todo lo que uno puede hacer ahí, sin embargo no son lo suficientemente amigables en grandes escalas.

Una herramienta muy útil para esto es Lightning AI es una biblioteca de Python que como ellos mismos la definen es "Pytorch acomodado". Les recomendamos mucho utilizar esta poderosa herramienta, muchas gracias a Francisco Marín Romero quien introdujo por primera vez estas técnicas en nuestros cursos. También en los cursos con Pablo Conte hemos enseñado esto.

Métricas flexibles

En algunos casos definir correctamente la manera de evaluar la calidad de un proceso puede ser muy complicado, esto ocurre a diario en una compañía pero también en una investigación científica.

Pensemos por ejemplo en el caso de AlphaFold el cual es un modelo matemático para predecir la estructura geométrica de una proteína utilizando la menor cantidad de información inicial. La evaluación de si una predicción es lo suficientemente precisa resulta en un problema muy complicado.

Para ello se desarrollaron métricas ad hoc motivadas por la industria biotecnológica. En nuestro curso sobre este tema junto a Alvaro de Obeso Fernandez del Valle explicamos el significado de estas métricas.

¿Dónde aprender más?

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).