BloombergGPT y la adecuación de los grandes modelos de lenguaje

Los Grandes Modelos de Lenguaje (LLM) son uno de los logros más sobresalientes de la inteligencia artificial, basta con abrir cualquier portal de noticias y buscar las publicaciones relacionadas con ChatGPT para dimensionar lo mucho que cambiará al mundo desde un aspecto industrial, social y científico.

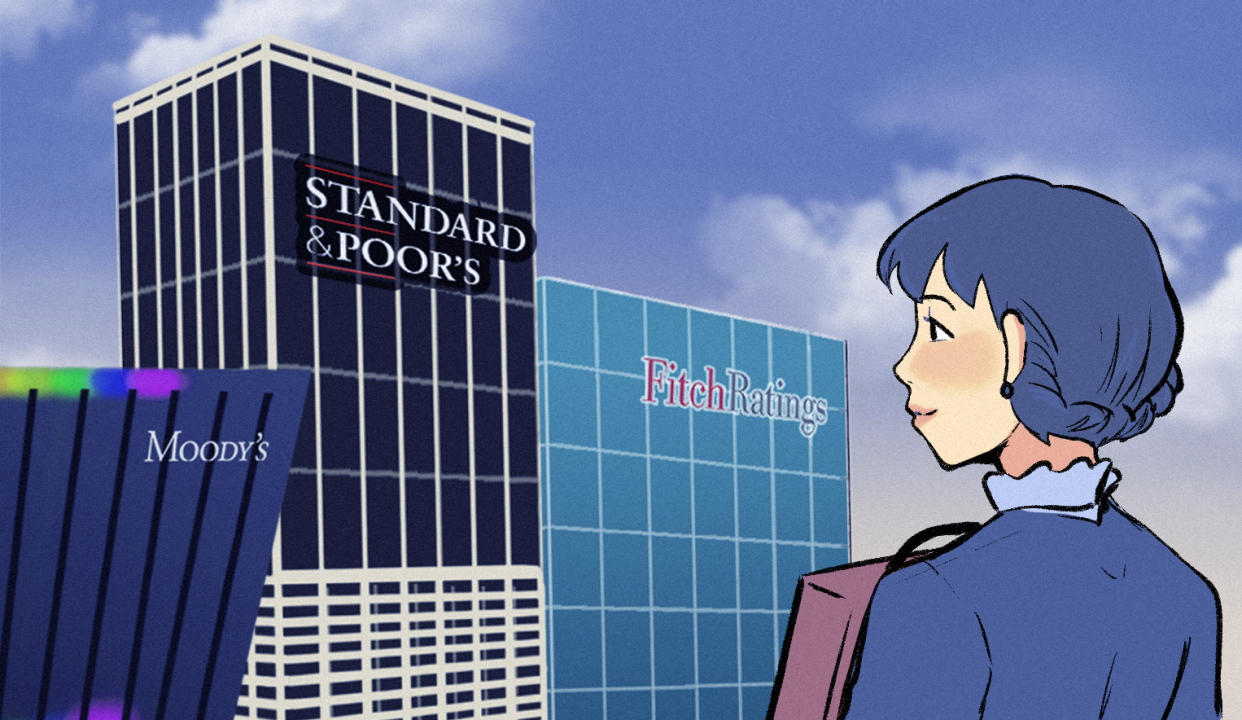

Recientemente el equipo de Bloomberg publicó un artículo en el que construyeron un gran modelo del lenguaje dedicado a una gran variedad de tareas relacionadas con problemas Financieros. Las implicaciones de este trabajo tanto con el sector FinTech como en el resto del Mercado Bursátil son gigantescas.

Relacionado con esto, he preparado el siguiente texto en el que comentaré dos aspectos nucleares sobre los grandes modelos del lenguaje y su relación con el sector Financiero:

- La especificidad de los LLM

- Las distintas arquitecturas de los LLM

Muchas gracias a mi amigo Enrique Covarrubias por llamar mi atención sobre este trabajo.

La especificidad: riesgos y virtudes

Sobre los LLM comúnmente me han preguntado algunos estudiantes del Colegio de Matemáticas Bourbaki qué tan absolutos son en el siguiente sentido:

Si el éxito de un gran modelo del lenguaje depende fuertemente de bases de datos gigantescas y generalistas, ¿existe la posibilidad de que en el futuro vayamos a utilizar un solo LLM para cualquier tarea?

Esta pregunta es muy relevante cuando recordamos por ejemplo cómo el algoritmo de búsqueda de Google se ha convertido en un monopolio virtual para los motores de búsqueda en internet.

También está motivada por la evidencia de habilidades emergentes en los LLM: el mismo Bill Gates cuenta cómo el gran reto que les dejó a los desarrolladores de ChatGPT fue que pueda aprobar exámenes que no aparezcan en el conjunto de entrenamiento.

Desde mi punto de vista en un mediano plazo los grandes modelos del lenguaje serán domain-specific inclusive cuando parte de su entrenamiento provenga de bases de datos generalistas.

Esto ya ocurre inclusive en el caso de los motores de búsqueda, por ejemplo cuando uno quiere buscar en una base de datos de patentes, existen otras alternativas bastante competitivas a la que ofrece Google. Lo anterior no depende únicamente de la base de datos pues recordemos que Google también tiene un motor de búsqueda de patentes.

Antes del modelo BloombergGPT ya existen versiones de LLM específicos para Lenguajes de Programación o Biomedicina los cuales han logrado un fantástico desempeño en tareas específicas del dominio (inclusive mejorando el benchmark) y al mismo tiempo se mantienen sus capacidades básicas como:

- Knowledge Assessments

- Reading Comprehension

- Linguistic Tasks

Es sin lugar a dudas muy emocionante lo que se avecina.

Aplicaciones financieras

Volviendo al caso específico de BloombergGPT, una de las aportaciones más interesantes de su trabajo es lograr un entrenamiento exitoso utilizando dos fuentes de texto muy distintas, por un lado bases de datos generalistas como ThePile y por el otro textos específicos relacionados con el mercado bursátil, en particular sus datos privados los cuales son sin lugar a dudas fundamentales para esta tarea.

Desde el punto de vista financiero, han puesto a prueba a BloombergGPT en tareas específicas del dominio e increíblemente ha mejorado a la gran mayoría de los modelos anteriores. En el Colegio de Matemáticas Bourbaki ya enseñábamos LLM aplicados exclusivamente al sector financiero en nuestro curso Aplicaciones Financieras de ML & AI, en la nueva edición estudiaremos esta nueva clase de modelos.

Los grandes gurús del sector financiero como mi amigo y co-fundador de Bourbaki Gerardo Hernandez-del-Valle entienden muy bien cómo las perspectivas del comprador y del vendedor pueden ser distintas, pero también el tipo de mercado ya sea el de derivados, cripto-activos o alguno otro influye mucho en los modelos matemáticos. Estas necesidades por supuesto que se trasladan a los LLM, aquí de forma lúdica incluyo algunos nombres provocadores:

- ¿FraudGPT?

- ¿RiskGPT?

- ¿CryptoGPT?

Encoder, Decoder & Encoder-Decoder

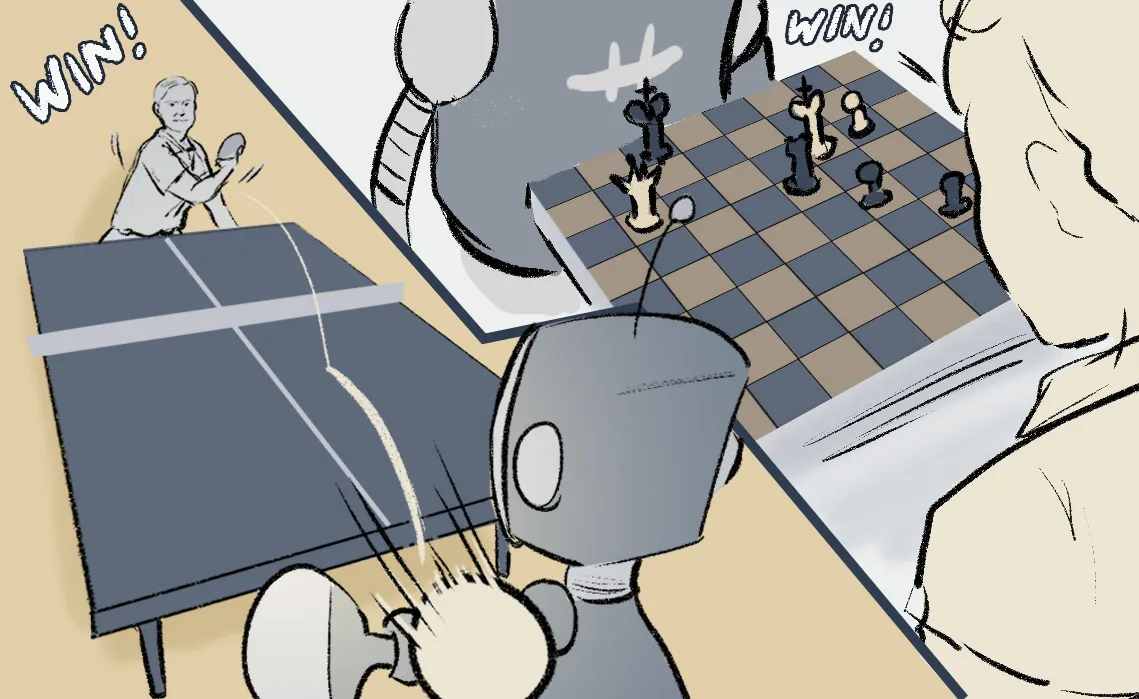

Los grandes modelos del lenguaje dependen enormemente de una familia de redes neuronales llamadas transformer, estas redes utilizan funciones de atención y fueron introducidas por primera vez para traducir textos.

La arquitectura original de estas redes neuronales es lo que se conoce en AI como un Encoder-Decoder y cuya idea básica se remonta a las técnicas de compresión de la información.

A medida que ha avanzado el tiempo, las arquitecturas que utilizan redes transformer han sido mejor comprendidas y nos hemos dado cuenta de que no siempre se debe utilizar una red Encoder-Decoder, de hecho el modelo de ChatGPT utiliza únicamente el Decoder. Por el otro lado el modelo que nosotros enseñábamos anteriormente el el curso de Aplicaciones Financieras de ML & AI, utilizaba solo el Encoder.

Es muy importante mencionar que aunque la base de datos de BloombergGPT está etiquetada a través del tiempo, el algoritmo de entrenamiento no lo está considerando. En el artículo ellos sugieren hacerlo en un futuro, en ese caso la elección de la arquitectura es crucial si tomamos en cuenta que la variable tiempo es crucial en los Mercados Financieros.

Oferta académica

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).