Estado del arte 2022: AI & Math

El Colegio de Matemáticas Bourbaki está muy contento por compartir con ustedes nuestra lista del estado del arte 2022 sobre innovaciones en Inteligencia Artificial y Matemáticas, hemos elegido los 11 avances científicos que desde nuestro punto de vista han revolucionado el estado del arte con más vehemencia estas áreas fundamentales para la transformación digital de las industrias y la investigación en academia.

Nuestra exhibición incluye una presentación in a nutshell de los logros más importantes en estas áreas. También vamos a compartir con ustedes tanto las ecuaciones más representativas de estos 11 avances científicos como algunas de las aplicaciones a la industria o a la academia correspondientes. ¡Estén pendientes!

Le agradecemos por su contribución a este post a nuestro amigo Juan Sebastian Ortega Briones quien es ingeniero en electrónica y comunicaciones además de director de Moviltrack una empresa dedicada a soluciones de identificación por radio frecuencia. Muchas gracias a Plácido Doménech Espí y xHUB.AI por su labor para la difusión de estos contenidos.

A continuación les presentamos la lista:

Stable Diffusion: generación de imágenes a partir de textos.

Hace algunos años se construyó por primera vez redes neuronales que son capaces de comprender la distribución que rige los parámetros de una familia de imágenes, por ejemplo se construyó una red neuronal que puede replicar pinturas de un periodo histórico específico, a estos modelos se les conoce como Generative Adversarial Networks y también son responsables de algunos ejemplos de Deep Fake. En 2022 por primera vez se construyó una red neuronal que además es capaz de generar estas imágenes siguiendo instrucciones en lenguaje natural, es decir que en lugar de entrenar un modelo con imágenes específicas para que logre aprender los patrones, solo le tenemos que decir cómo esperamos ver la imagen.

ChatGPT: un modelo de conversación

Utilizando como base los grandes modelos del lenguaje ya entrenados como GPT3.5, OpenAI construyó un modelo de NLP que lee preguntas sobre temas variopintos y responde en lenguaje natural. Un ejemplo de las preguntas que les podríamos hacer es por una formulación química, en este caso el modelo responde con una propuesta de cuáles químicos utilizar y cuáles son los pasos para lograr esta reacción química. Otra posible pregunta que ChatGPT responde satisfactoriamente es sobre consejos para organizar una ronda de inversión con Family & Friends sobre algún proyecto de emprendimiento. Las aplicaciones de este modelo son innumerables y los resultados que ha arrojado son verdaderamente prometedores sin embargo debemos recordar que estos modelos aún se encuentran en desarrollo y podrían tener errores.

Multiplicación veloz de matrices vía aprendizaje por refuerzo

De la multiplicación de matrices dependen muchas de las rutinas que realizan los sistemas automatizados y además los entrenamientos de modelos de Inteligencia Artificial, por esto es que multiplicar matrices eficientemente es uno de los problemas más importantes para la Ciencia de la Computación. Muchos matemáticos desde hace más de 50 años han investigado sobre este problema y han propuesto técnicas muy ingeniosas para realizarlo sin embargo 2022 será recordado como la primera ocasión cuando un modelo de inteligencia artificial propuso técnicas para optimizar esta multiplicación de matrices que mejoran las propuestas por los seres humanos.

Transformers e inferencia causal para datos tabulares

A menudo se asocian las bases de datos tabulares y supervisadas a modelos "clásicos" de Machine Learning excluyendo a las redes neuronales. En 2022 se entrenó una arquitectura de redes neuronales que cambia por completo el enfoque anterior utilizando ideas de la inferencia bayesiana. Su nombre es TapPFN es un modelo que se asemeja más a un programa de Auto Machine Learning que no requiere un calibrado de parámetros óptimos lo cual permite realizar entrenamientos complicados en cuestión de segundos.

Generación de código para lenguajes de programación

Los lenguajes de programación como R, Python, Java son la manera como nos comunicamos con las computadoras para instruir alguna tarea, por ejemplo entrenar un modelo de inteligencia artificial. Poder redactar instrucciones óptimas es una tarea que requiere inteligencia pues más allá de hablar correctamente el lenguaje de programación, la lógica de estas instrucciones podría necesitar razonamiento matemático. La compañía DeepMind logró construir un modelo matemático que realiza este tipo de instrucciones resolviendo estos problemas lógicos, de hecho lo hace tan bien que es competitiva con los seres humanos.

Un nuevo chip para mejorar el consumo energético de modelos de AI

El uso de AI en la vida diaria es cada vez más común, sin embargo, su adopción está limitada por el consumo energético de los dispositivos (cámaras, relojes y bandas inteligentes, etc.). Estos modelos requieren una enorme cantidad de procesamiento que se traduce en gasto energético, los modelos están basados en multiplicación de matrices, el gran avance tecnológico de estos chips es cambiar el paradigma de hacer las multiplicaciones del mundo digital al mundo analógico, por ejemplo, una multiplicación de un número de 8 bits en el mundo digital requiere alrededor de 1,000 transistores, mientras que en el mundo analógico solo requiere una resistencia. Esto se traduce en una reducción muy importante en tamaño y consumo energético.

La arquitectura actual de las computadoras está basada en un CPU y memoria conectados a través de una carretera llamada bus de datos, esta carretera tiene una cantidad limitada de tráfico y con operaciones complejas se satura, al estar moviendo los números de las matrices que se tienen multiplicar, de la memoria al CPU para hacer la multiplicación y del CPU a la memoria para guardar el resultado genera tráfico intenso y alto consumo energético, esto nos lleva a una velocidad limitada por el bus y el alto consumo energético genera calor, que tenemos que disipar con ventiladores o con una masa grande de metal.

Estos nuevos chips (NeuRRAM), son específicos para realizar estas operaciones y no usan el bus de datos, son llamados computadoras en memoria porque además de alojar los números de las matrices, calculan la multiplicación sin transferencia por el bus, por esto, son extremadamente eficientes y pequeños, aunque específicos para esta tarea. Ya hay empresas que los están produciendo y comercializando para aplicaciones de visión por computadora en cámaras que clasifican con consumos muy bajos de energía por lo que se alimentan con pequeños paneles solares. En el futuro cercano tendremos relojes inteligentes que podrán recargarse una vez al mes en lugar de todos los días.

Un contraejemplo para la conjetura de las teselaciones

Una teselación es una manera de cubrir un espacio infinito utilizando una variedad finita de piezas, evidentemente necesitamos una cantidad infinita de ellas pero las distintas formas serán finitas, pensemos por ejemplo en los hexágonos con los que se construyen los panales de las abejas en este caso solo es una sola figura. La mayor parte de las teselaciones que podemos imaginar son periódicas, es decir que es posible recorrer todas las piezas y la figura se quedará igual, sin embargo hace algunas décadas el ganador del premio Nobel de Física, Roger Penrose demostró que existen teselaciones que no son periódicas y además no contienen ninguna franja que sea periódica, a estas las llamaremos aperiódicas. Este año los matemáticos Terence Tao y Rachel Greenfeld demostraron que en dimensiones superiores a dos, existen teselaciones aperiódicas y que no son periódicas en las que no permitiremos rotar nuestras piezas, este resultado es poco intuitivo porque está demostrado que en dos dimensiones lo anterior no se cumple. Durante varios años se creyó que este resultado era imposible y por lo tanto estos ejemplos son inesperados.

Los ceros de Siegel Landau y los números primos

Los números primos son los átomos con los que se construye el resto de los números naturales y su comportamiento es el misterio más grande para los matemáticos interesados en la aritmética. Una de las técnicas más utilizadas para estudiar a los números primos es construir una función cuyos valores nulos dependen de alguna propiedad de ellos. En Noviembre de 2022 el matemático Zhang afirmó que una familia de funciones conocidas como funciones L se alejan lo suficiente del cero y así podríamos garantizar que los números primos son aún más frecuentes de lo conocido, por ejemplo si lográramos mejorar aún más la afirmación de Zhang, sería posible demostrar que existen una infinidad de parejas de números primos cuya diferencia sea solo dos. Hace algunos años el trabajo de Zhang saltó a la fama porque demostró que existen una cantidad infinita de parejas con una diferencia de centenas.

La conjetura sobre las burbujas en dimensiones superiores

¿Cuál es la forma geométrica que minimiza el área de la superficie? Arquímedes sugirió que la respuesta a este problema es una esfera. Aunque este enunciado parezca muy sencillo, no fue demostrado con rigor matemático hasta el siglo XIX por el alemán Hermann Schwarz. Ahora supongamos que tenemos dos objetos con un volumen fijo pero moldeables en tres dimensiones como por ejemplo las pompas de jabón. Nos gustaría acomodarlos de tal manera que el volumen se mantenga constante pero el área de la superficie se minimice pues no quieren arriesgarse a ser pinchadas, por supuesto que la idea inicial es juntar los objetos pues si están separados el área es máxima. En 2022 se demostró matemáticamente que los análogos en muchas dimensiones de estos acomodos tipo pompas de jabón también son óptimos.

Computadora prueba la existencia de soluciones infinitas sobre mecánica de fluidos

El 2022 ha sido un año muy importante para las ecuaciones de Euler, estas ecuaciones permiten modelar la mecánica de fluidos a través del tiempo, es decir que predicen por ejemplo la dinámica de la circulación de nuestra sangre o cómo fluye el aire en las alas de un avión. Estas ecuaciones podrían o no tener una singularidad en algún momento del tiempo, lo cual significa que predicen un valor infinito lo cuál no tiene sentido físico. Recientemente utilizando computadoras para realizar complicados cálculos, se logró demostrar que incluso utilizando parámetros iniciales completamente realistas las ecuaciones pueden tener singularidades.

Los agujeros negros de Kerr son matemáticamente estables

Los agujeros negros están clasificados de acuerdo a sus propiedades matemáticas, una familia muy importante son los conocidos como agujeros negros de Kerr los cuales poseen momento angular. Sobre estos se conjeturó hace algunos años que son estables respecto a algunas perturbaciones. En Machine Learning la estabilidad es una propiedad muy importante que explica la razón de cambio de un modelo respecto a las bases de datos, la idea general es que si un algoritmo es muy sensible a pequeñas perturbaciones del dataset entonces tendrá más posibilidades de sobreajustar lo cual es indeseable dentro de ciencia de datos. En 2022 se demostró matemáticamente que los agujeros negros de Kerr son matemáticamente estables lo cual es uno de los grandes avances en el área.

Track a través de la Ciencia de Datos.

En el Colegio de Matemáticas Bourbaki ofrecemos un curso de 49 semanas de duración en la que los estudiantes pueden comenzar desde los conceptos más básicos tanto de programación como de matemáticas y convertirse en profesionales de la ciencia de datos que hayan practicado gracias a nuestras tareas y proyectos. Los invitamos a conocer más detalles en el siguiente brochure.

Oferta académica

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

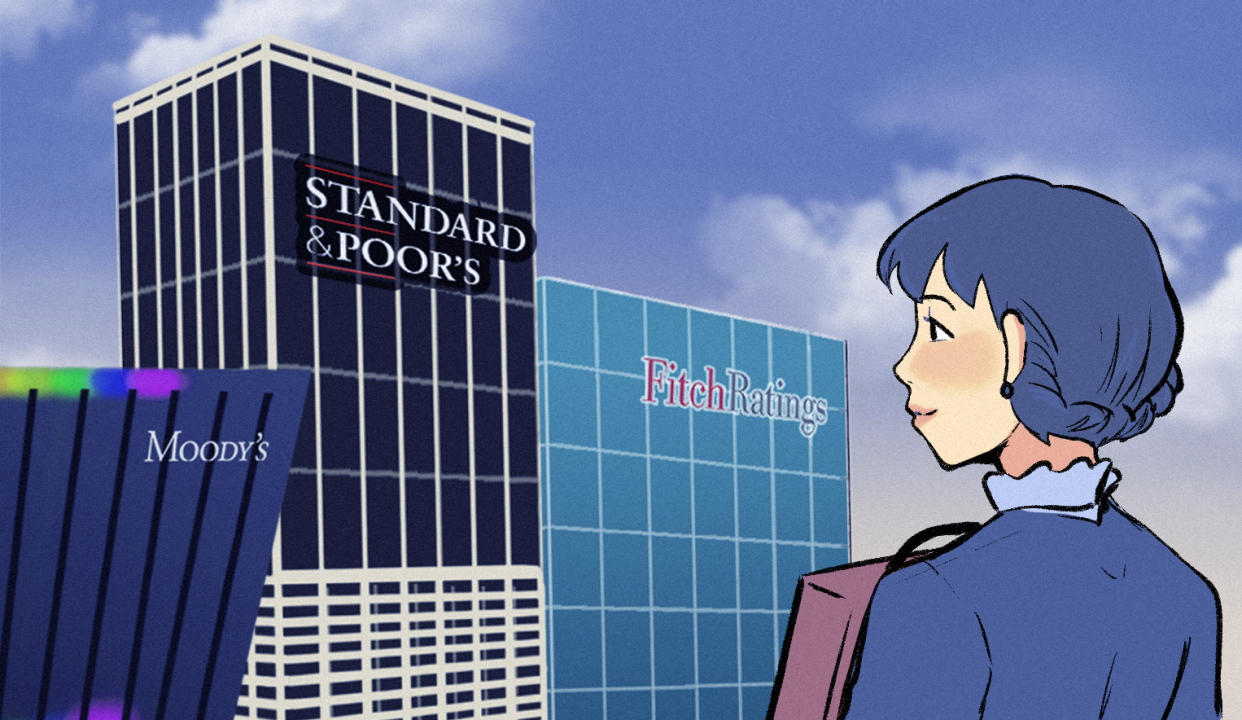

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).