IA neuro-simbólica para olimpiadas matemáticas

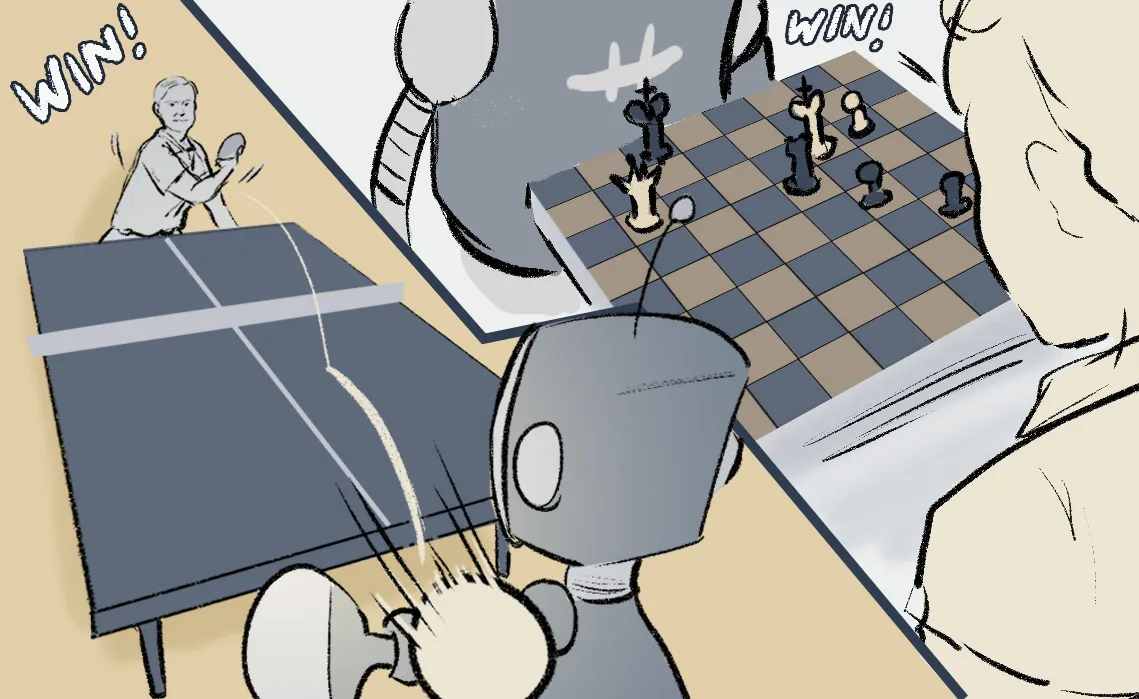

Desde hace algunos años he utilizado el ejemplo de las medallas de oro en la Olimpiada Internacional de Matemáticas (IMO) para señalar uno de los grandes retos que tiene la Inteligencia Artificial. En particular los problemas relacionados con Geometría Euclidiana son extremadamente complicados pues la deducción lógica no es suficiente al necesitarse construcciones auxiliares que requieren creatividad.

Hace dos días un equipo de Google DeepMind y New York University propusieron un modelo matemático llamado AlphaGeometry que utiliza tanto Inteligencia Artificial Simbólica como Modelos Neuronales Auto-Regresivos para por primera vez, alcanzar el número de aciertos que un medallista de oro promedio de la IMO obtiene en problemas de geometría euclidiana plana.

Además de presentar los resultados de este modelo matemático vamos a explicar en cómo utiliza a modelos tipo GPT o motores deductivos simbólicos para proponer soluciones fuera del alcance de las inteligencias artificiales actuales.

Estado del arte

Existen otros métodos para intentar resolver este tipo de problemas, entre ellos un reciente esfuerzo hecho por OpenAI el cual no funciona correctamente para problemas geométricos, sin embargo sí podríamos preguntarnos cómo lo hace GPT-4 el cual es multimodal y sorprendentemente obtuvo un éxito de 0% en estos experimentos. Otros acercamientos son mediante la reducción a la solución de ciertos polinomios u otras técnicas ad hoc en las que se introducen estrategias previas.

De 30 problemas de olimpiadas a los que se enfrentó AlphaGeometry acertó en 25 lo cual es el promedio de aciertos para los participantes que han ganado medallas de oro en el pasado. Además, una de las demostraciones que propuso a uno de los problemas no solo fue correcta sino que generalizó el enunciado original. Sin lugar a dudas uno de los logros más notables en los últimos años, parece difícil pero DeepMind nos continúa sorprendiendo.

Thinking, Fast & Slow

Para comprender mejor la complejidad de lo que pueden hacer este tipo de modelos vamos a presentar un ejemplo del mismo artículo el cual mostrará la idea general del enfoque neuro-simbólico detrás de AlphaGeometry.

Tal y como lo explican en su presentación, la idea general detrás de utilizar tanto modelos generativos como sistemas deductivos simbólicos es imitar el proceder de la inteligencia descrito por Daniel Kahneman en su libro Thinking, Fast & Slow. De acuerdo a este libro, será la componente FAST de nuestra inteligencia la que impulsivamente y de manera creativa mientras que la componente SLOW será quien logre deducciones contemplativas.

Un ejemplo sencillo

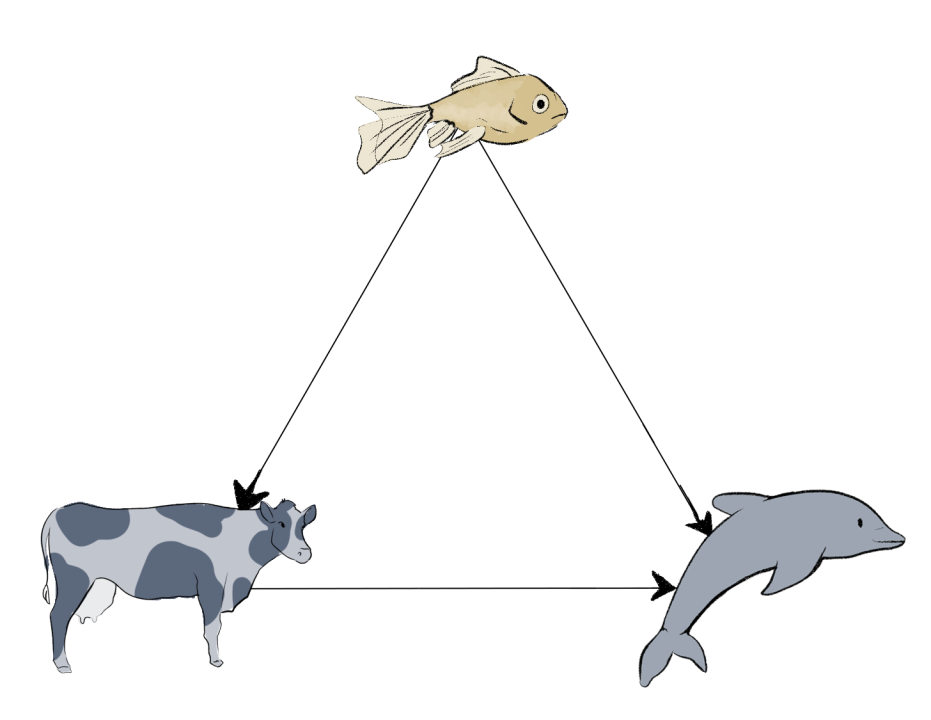

Pensemos en un triángulo con vértices A, B y C del cual únicamente sabemos que sus lados AB y AC miden lo mismo. El reto es deducir que los ángulos ABC y ACB también miden lo mismo. Los axiomas de la geometría euclidiana, las nociones comunes y las reglas lógicas básicas no son suficiente para deducir el resultado.

Lo que haría un matemático sería lo siguiente: construyamos el punto medio del lado BC y llamémosle D, el siguiente razonamiento es automático y lo puede hacer motor de deducción simbólica que conozca los axiomas, las nociones comunes y las reglas lógicas de la geometría euclidiana.

- Gracias a la hipótesis y a la construcción del punto D, sabemos que los triángulos ABD y ACD tienen todos sus lados iguales, es decir que podrían ser el mismo triángulo.

- Como los lados AB=AC y BD=CD, entonces necesariamente los ángulos ABD y ACD serán iguales.

- Gracias a que los puntos BDC son colineales, entonces también los ángulos ABC y ACB son iguales lo cual concluye la demostración.

Notemos que sin la construcción del punto D o alguna otra astucia, no habríamos demostrado este resultado tan sencillo, por el otro lado la elección de construcciones que pudimos haber hecho es verdaderamente gigantesca: dibujar un círculo inscrito en el triángulo, tres círculos con diámetros los lados del triángulo, dibujar los puntos intermedios de los otros lados y así un infinito etcétera.

La elección del punto D será tarea de la componente FAST y la deducción que acabamos de enlistar será la SLOW.

I: Generación simbólica del data set

El método para construir el dataset con el que se entrenó el modelo GPT desde cero, es una de las partes más interesantes del trabajo e indispensable debido a la falta de datos supervisados para la demostración de teoremas matemáticos, nuestras X serían los enunciados y nuestras variables objetivo Y las demostraciones. Evidentemente esta base de datos etiquetada está fuera del alcance actual, por ello es necesario construirla.

Para comenzar la generación aleatoria de la base de datos se establecieron construcciones geométricas a las que llamaremos las hipótesis y denotaremos por X, estas podrían ser por ejemplo la descripción del triángulo ABC anterior. A partir de ahí utilizando deducciones lógicas como las que enlistamos en la demostración del resultado se generaban nuevos dibujos, cada uno de los cuales será el nodo de un grafo acíclico dirigido y llamaremos X' o teorema.

Notemos que entre una hipótesis X y un teorema Y, el grafo dirigido anterior podría tener demasiados caminos posibles, en este paso se propone un algoritmo muy interesante parecido a pruning al que ellos llaman Traceback Algorithm, el output de este algoritmo es una versión mínima de la demostración a la que denotaremos por Y. A esta base de datos con columnas (X,X',Y) la llamaremos S.

II: Entrenamiento de un transformer

Utilizando la base de datos anterior (X,X',Y) se entrenó de manera supervisada un modelo generativo auto-regresivo en el que podemos entender a (X,X') como el prompt de nuestro modelo.

Es notable que este modelo se entrenó desde cero con un dataset original de 100 millones de registros y se le hizo un fine-tuning utilizando únicamente el 9% de los datos que requerían una construcción auxiliar proveniente del modelo de lenguaje inicial.

III: Loop neuro-simbólico

El modelo final es una mezcla entre el motor de deducción simbólica con el que se construyó el dataset S el cual corresponde a la componente SLOW y el modelo Transformer entrenado con S.

El modelo AlphaGeometry en su primera iteración a una hipótesis X la evaluará en nuestro motor neuro-simbólico, si encuentra el resultado entonces habremos terminado, de otra manera se introduce en al modelo GPT para generar una construcción auxiliar la cual cambiará a nuestras hipótesis iniciales. Nuevamente se evaluará esta actualización en el modelo neuro-simbólico. Las iteraciones continúan hasta lograr una demostración Y.

Oferta académica

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).