Matrices aleatorias: donde habita el olvido

La reducción de la dimensión de la información es una tarea indispensable en el modelado matemático de cualquier fenómeno, desde que Joseph Fourier estudió la ecuación del calor por medio de las funciones trigonométricas sus ideas han permeado la física, la genética, las ciencias de la computación y por supuesto el análisis de los datos.

Bien entendida la reducción de la dimensión es un proceso de olvido, para que este proceso sea ideal se debe mediar entre dos objetivos que podrían parecer contradictorios:

- Olvidar la mayor parte del ruido o características que no sean necesarias para nuestra variable objetivo.

- Poder recuperar una buena parte de la información original dentro de mi conjunto de datos.

Quienes tengan experiencia en conceptos básicos de machine learning sabrán distinguir en los objetivos anteriores a las dos fuerzas que rigen esta área: sobre-ajuste y sub-ajuste.

En esta edición de nuestro Bourbakisme hemos decidido hablar sobre cómo los objetivos anteriores son perseguidos por dos técnicas para reducir la dimensión: Análisis de Componentes Principales y el lema de Johnsson-Lindenstrauss.

Sistemas de recomendación

Para ejemplificar mejor el uso de estos algoritmos vamos a suponer el siguiente problema:

A una compañía dedicada a rentar servicios de streaming le gustaría comprender mejor la experiencia de los usuarios y deciden utilizar las reseñas de sus contenidos, existen dos problemas comunes a los que se podrían enfrentar los analistas:

- Los datos no son estructurados, pues son textos enviados por los usuarios.

- Vectorizar estos textos con técnicas como one-hot encoding requiere una dimensión cercana a los miles.

El Análisis de los Componentes Principales

Supongamos que hemos elegido una bolsa de palabras para vectorizar nuestros textos, digamos de unas 1,000 palabras. Un objetivo bastante ambicioso sería lograr reducir la dimensión por ejemplo a dos características pues esto nos permitiría por lo menos poder visualizar nuestros datos en un plano cartesiano.

El análisis de componentes principales funciona muy bien cuando por ejemplo existen dos grupos de palabras claramente correlacionados dentro de nuestra bolsa, por ejemplo:

Imaginemos que por un lado existen palabras relacionadas con la atención que recibieron los clientes durante la contratación (precio, facturación, pago, etc.) y por el otro lado hay algunas palabras relacionadas con el contenido de los videos (terror, documentales, Nicole Kidman, etc.).

En este caso el análisis de componentes principales lograría resolver satisfactoriamente el problema del sobreajuste pues estaría quitando el ruido que generan palabras distintas pero relacionadas. Desafortunadamente la hipótesis anterior podría no cumplirse cabalmente y esto significa que este método no funciona correctamente.

El lema de Johnsson-Lindenstrauss

En el año de 1984 se publicó el artículo Extensions of Lipschitz mappings into a Hilbert Space el cual trataba un problema muy similar al que hemos planteado pero en espacios de dimensión infinita, los cuales no son tan comunes en ciencia de datos. Afortunadamente su resultado también es válido para bases de datos “usuales".

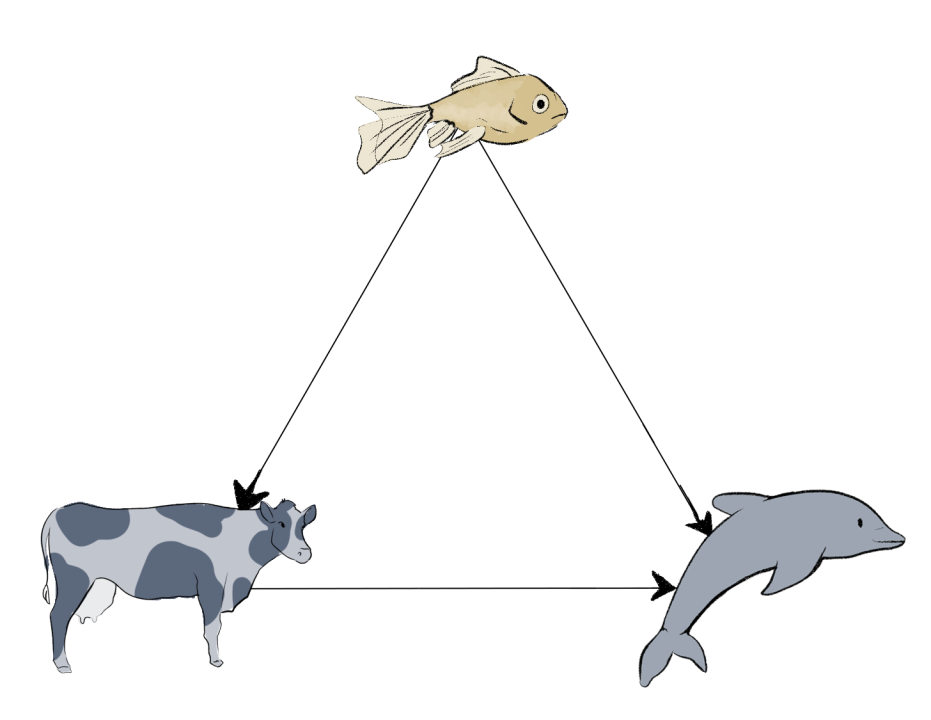

Cuando no existen correlaciones lineales entre las características de una base de datos como en la hipótesis que hicimos en la sección anterior, el análisis de componentes principales difícilmente funcionará correctamente. Podemos exagerar pensando que las palabras que aparecen en la bolsa son genuinamente sobre temas distintos y en este caso el análisis de componentes principales inmediatamente sub-ajustará.

El lema de Johnsson-Lindenstrauss sugiere que si la dimensión a la que deseamos reducir no es tan pequeña como el plano cartesiano pero nos gustaría preservar las distancias entre los elementos de la base de datos, si elegimos al azar (pero al mismo tiempo cuidadosamente) la matriz con la que se reducirá la base de datos entonces es posible reducir el problema del sub-ajuste.

Oferta académica

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).