Premio Princesa de Asturias, Deep Learning y sus Matemáticas

Las redes neuronales profundas son un objeto tan importante para las matemáticas aplicadas y la ciencia de la computación que probablemente un día no será arriesgado compararlas con las ecuaciones diferenciales tan solo por poner un ejemplo.

Su versatilidad nos permite construir complejos edificios con los cuales podemos introducir nuestras ideas sobre la arquitectura correcta para solucionar un problema utilizando datos.

El 15 de Junio de 2022 será recordado en la comunidad (académica pero también industrial) que interactúa de alguna manera con Deep Learning como el día en el que la Fundación Princesa de Asturias les otorgó el PREMIO DE INVESTIGACIÓN CIENTÍFICA Y TÉCNICA 2022 a cuatro de los exponentes más importantes de esta área.

El Colegio de Matemáticas Bourbaki ha decidido dedicarle esta edición de su boletín BOURBAKISME a divulgar algunos de los aspectos matemáticos involucrados en el trabajo de los galardonados: Geoffrey Hinton, Yann LeCun, Yoshua Bengio y Demis Hassabis.

Al final hemos incluido las referencias más relevantes en orden de aparición dentro de este artículo.

Geoffrey Hinton

Estudió su doctorado en inteligencia artificial y ha dedicado la mayor parte de su trabajo a investigar una de las preguntas más complicadas de toda la ciencia: ¿cómo funciona el cerebro?

Sobre los aspectos matemáticos de su trabajo hemos elegido los siguientes tres temas notables:

Backpropagation

Las funciones definidas por las redes neuronales son complicadas composiciones que representan el paso conocido como forward entre las distintas capas. Por el otro lado una de las técnicas de optimización para el entrenamiento de los modelos matemáticos es el algoritmo propuesto por Cauchy conocido como el Descenso por Gradiente el cual requiere calcular el gradiente de la función de pérdida. En matemáticas a la armonía entre la composición de funciones y la derivada se le conoce como la regla de la cadena. Hinton propuso en 1986 por primera vez un algoritmo explícito utilizando a la regla de la cadena para calcular el gradiente de funciones compuestas el cual hoy se conoce como backpropagation.

GLOM y el teorema Kolmogorov-Arnold

Recientemente Hinton publicó un artículo titulado GLOM el cual propone un nuevo paradigma en la representación de información espacial. Aunque el artículo publicado por Hinton no presenta un sistema en funcionamiento, sí explica detalladamente cuáles son las analogías tanto biológicas como matemáticas. Desde un punto de vista matemático Hinton sugiere que el teorema de superposición de Kolmogorov-Arnold es una manera correcta de representar los features de una imagen. Este teorema es la solución a uno de los problemas planteados por Hilbert y explica que cualquier función continua en varias (muchas) variables puede re-escribirse únicamente utilizando la función de dos variables suma (F(X,Y)= X + Y) y otras funciones uni-variadas. Es quizás la primera vez que las ideas de este teorema han sido relacionadas con modelos neuronales.

Yann LeCun

Él estudió ingeniería eléctrica en París y actualmente es el Chief AI Scientist en Meta. Es uno de los científicos más influyentes en el desarrollo pero también en la implementación de las redes neuronales profundas.

Entrenando convoluciones

Las convoluciones es un objeto matemático que permite operar parejas de funciones y tiene sus raíces en el trabajo de Fourier sobre las representaciones trigonométricas de funciones para resolver la ecuación diferencial del calor. Estos objetos se había utilizado anteriormente en redes neuronales para clasificar dígitos sin embargo los parámetros que se utilizaron en los trabajos previos a LeCun estaban fijos y fueron elegidos manualmente. Posiblemente él fue la primera persona en utilizar el algoritmo de Backpropagation para entrenar estos parámetros utilizando la supervisión de los datos. Esta idea osada de entrenar no solo funciones densas sino otros objetos es quizás el corazón detrás de los recientes avances en inteligencia artificial.

Joshua Bengio

Él es un informático que ha colaborado de alguna manera en algunos de los proyectos más importantes en redes neuronales, colaboró con LeCun en alguno de sus primeros proyectos sobre el reconocimiento de dígitos.

Memoria de largo plazo

Aunque las redes neuronales recurrentes existían desde los años 80's uno de los trabajos de Bengio permitió señalar el que quizás es su principal obstáculo, a saber la memoria a largo plazo. Desde un punto de vista estadístico este problema está relacionado con el posible sobre-ajuste que tienen los modelos recurrentes en los que observaciones lejanas en el tiempo influyen en las nuevas predicciones. Desde un punto de vista de optimización, Bengio y sus colaboradores señalaron las enormes dificultades que tendría el entrenamiento mediante el método del gradiente de redes con memoria de largo plazo. Afortunadamente este problema fue solucionado elegantemente por las redes Long Short Term Memory.

Encoder-decoder

Las ideas de la reducción de la dimensión han permeado a las matemáticas aplicadas en muchos aspectos, de hecho el Premio Príncipe de Asturias de 2020 galardonó a otros 4 matemáticos por su trabajo relacionado con la teoría de la compresión. En un círculo de ideas parecido, Bengio propuso una arquitectura que permite reducir la dimensión de la información utilizando las bondades de las redes neuronales. Es sobresaliente que el entrenamiento de estos modelos siga funcionando bien con las técnicas clásicas.

El mecanismo de atención

Aunque la versión más moderna del mecanismo de atención no es la introducida por Bengio y sus colegas, la idea de un mecanismo entrenable que permita dirigir la atención a subregiones dentro de una red neuronal fue propuesta originalmente en lo que hoy conocemos como el mecanismo de Bahdanau. Gracias a las versiones más sofisticadas de este mecanismo es que las redes neuronales han logrado avances sin precedentes para el lenguaje natural.

Generative Adversarial Networks

El uso de GAN's para deep fake las ha convertido en un objeto increíblemente llamativo para los aprendices en inteligencia artificial. Desde un punto de vista matemático es muy interesante cómo ideas provenientes de la teoría de juegos como son los juegos de suma cero permitan plantear problemas de optimización plausibles. En este caso se propuso un juego de suma cero entre un modelo generativo y un modelo discriminativo arrojando resultados fabulosos.

Demis Hassabis

Desde joven fue un prodigio interesado tanto en el ajedrez como en la programación, estudió en Cambridge Ciencias de la computación y fundó una de las compañías más importantes en la historia de la inteligencia artificial: DeepMind. Es co-autor de 5 portadas para la revista Nature y su trabajo científico y de gestión ha revolucionado la inteligencia artificial como nunca antes.

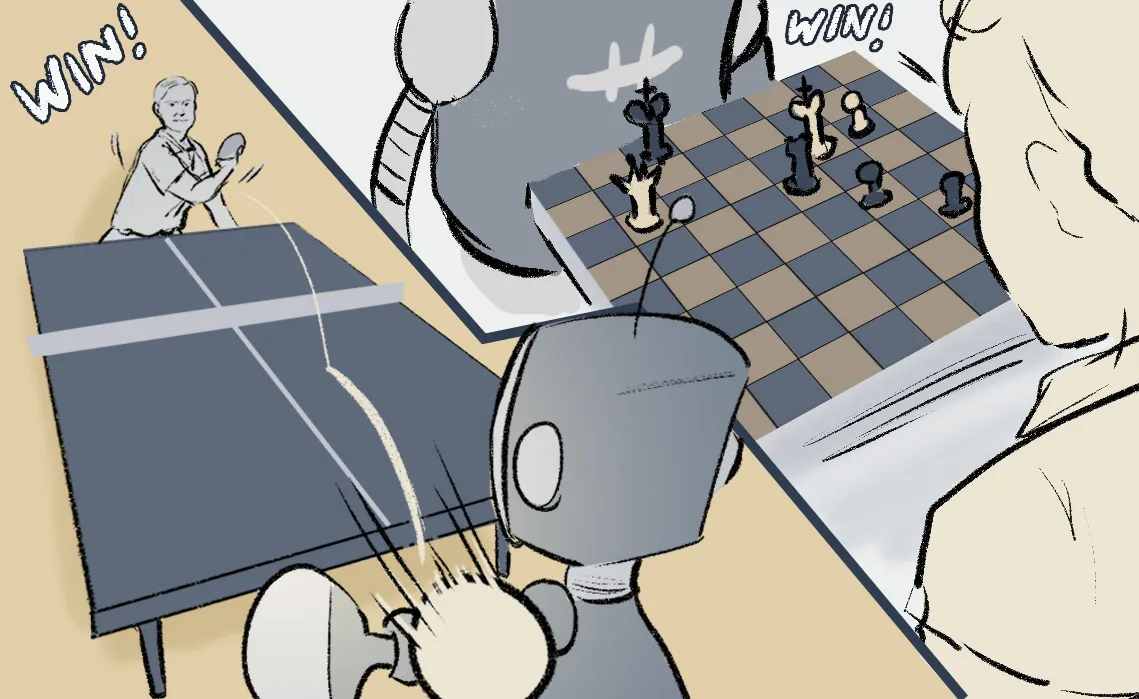

Deep reinforcement learning

Richard Bellman propuso una solución para muchos problemas complicados de optimización mediante el descubrimiento de algunas recurrencias internas, lo que hoy se conoce como las ecuaciones de Bellman. Estos objetos son muy importantes en inteligencia artificial pues permiten resolver problemas de control, por ejemplo un modelo que desee jugar ajedrez o Go. Las redes neuronales han logrado aproximar exitosamente las complejas políticas que definen a la solución de un problema de control.

Bajo la dirección de Hassabis DeepMind propuso dos de las arquitecturas más exitosas en la batalla entre humanos y modelos matemáticos para distintos juegos: AlphaGo y AlphaStar las cuales lograron performance inimagibales en Go y Starcrapht.

AlphaFold

Además de las aplicaciones utilizando Deep Reinforcement Learning en Deep Mind recientemente han resuelto uno de los problemas más complicados de toda la ciencia, a saber la descripción del desdoblamiento de proteínas. Es posible que estas redes neuronales hayan logrado comprender el intrincado lenguaje de las proteínas.

¿Dónde aprender más?

En el Colegio de Matemáticas Bourbaki ofrecemos cursos para capacitar a los estudiantes que deseen comenzar sus estudios o profundizar en la comprensión de los modelos matemáticos mencionados en este artículo.

Estamos orgullosos por ofrecer el mejor contenido de hispanoamérica sobre estos temas, muchas gracias a todos nuestros ex-alumnos por permitirnos mejorar diariamente el contenido que ofrecemos.

Nuestros cursos incluyen casos de uso reales implementados en Python o en R, cada semana se trabaja con una base de datos distinta y el curso incluye las explicaciones matemáticas de los modelos.

Los cursos que están por comenzar son:

- Especialización en Deep Learning : Es un curso avanzado sobre las redes neuronales profundas para imágenes, texto, datos multi-modales y datos estructurados, en el curso estudiaremos redes densas, convolucionales, recurrentes, GAN's y Deep Reinforcement Learning. El curso será en Python y no es necesario tener conocimientos previos pues habrá un propedéutico desde cero para los inscritos. Pueden consultar el temario en esta liga.

- Las Matemáticas de la Ciencia de Datos : Quienes estén interesados en aprender las bases matemáticas de Probabilidad y Estadística, Álgebra Lineal, Cálculo y Optimización necesarias para la Ciencia de Datos encontrarán en este curso el contenido ideal. El curso será en Python y no es necesario tener conocimientos previos pues habrá un propedéutico desde cero para los inscritos. Pueden consultar el temario en esta liga.

- Machine Learning & AI for the Working Analyst : Quienes deseen un curso intensivo para adentrarse en las técnicas de machine learning aplicadas a negocios encontrarán en este curso una capacitación ideal que combina la práctica con la teoría. El curso será en Python y no es necesario tener conocimientos previos pues habrá un propedéutico desde cero para los inscritos. Pueden consultar el temario en esta liga.

- ML & AI for the Working Analyst España : Quienes deseen un curso intensivo para adentrarse en las técnicas de machine learning aplicadas a negocios encontrarán en este curso una capacitación ideal que combina la práctica con la teoría. El curso será en Python y no es necesario tener conocimientos previos pues habrá un propedéutico desde cero para los inscritos. Pueden consultar el temario en esta liga.

Si desean conocer más detalles sobre alguno de los cursos o recibir una de las clases muestras o notas del curso con gusto pueden contactarnos en info@colegio-bourbaki.com

Títulos de los artículos mencionados

- Learning representations by back-propagating errors.

- How to represent part-whole hierarchies in a neural network.

- Backpropagation Applied to Handwritten Zip Code Recognition.

- Learning Phrase Representations using RNN Encoder–Decoder for Statistical Machine Translation

- Neural Machine Translation by Jointly Learning to Align and Translate.

- Generative Adversarial Networks.

- Grandmaster level in StarCraft II using multi-agent reinforcement learning.

- Highly accurate protein structure prediction with AlphaFold.

Oferta académica

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).