Simetrías, deep learning y productos derivados.

Las redes neuronales profundas son uno de los objetos más misteriosos que existen tanto desde el punto de vista computacional como desde el punto de vista matemático.

Actualmente podemos encontrar muchas de ellas libres en la naturaleza (departamentos de análisis en compañías, laboratorios de investigación, etc.) y aún no quedan clara cuál es la taxonomía final sobre el prior inducido por las distintas arquitecturas de las redes neuronales.

En esta edición de nuestro boletín BOURBAKISME vamos a hablar sobre cómo la teoría matemática de grupos de simetrías podría caracterizar a la geometría implícita en las bases de datos por medio de las distintas arquitecturas utilizadas en Deep Learning.

Recientemente en el contexto de Opciones Financieras se ha descubierto una familia de redes neuronales capaces de inducir la célebre hipótesis de la ausencia de arbitraje en el mercado de las opciones financieras y esto inevitablemente nos hace pensar si este tipo de datos respetan algún tipo de simetría que le corresponde a esa arquitectura.

Al final del texto encontrarán las referencias a dos trabajos que inspiraron esta edición.

Teoría de grupos y simetrías

Una simetría es una transformación de un espacio geométrico que preserva alguna propiedad del objeto, por ejemplo el significado de un palíndromo es respetado por la simetría de reflejar las letras en un espejo colocado verticalmente en el punto medio del palíndromo. Si por el contrario colocamos el espejo de manera horizontal, entonces no todas las letras se leerán igual pues no son simétricas, por ejemplo la letra O lo es y la A no lo es.

Una tarea emocionante es dado un objeto geométrico, combinatorio, financiero, etc. determinar cuál será su grupo de simetrías, es decir encontrar no solo cuáles son las simetrías de este objeto sino también cómo interactúan entre ellas.

El programa de Klein: Erlanger

En 1872 el gran matemático Felix Klein propuso lo siguiente: conocer las simetrías de un objeto es una manera de descubrir las características geométricas, combinatorias, financieras, etc de un objeto. Esto quiere decir que existe una reciprocidad entre nuestros objetos de estudio y sus grupos de simetrías. A este programa se le conoce como Erlanger.

De acuerdo con el programa Erlanger, conocer todas las propiedades simétricas (y asimétricas) de los palíndromos sería suficiente para caracterizarlos y saber con certeza que estamos hablando de los palíndromos.

Convoluciones

El programa Erlanger ha llegado a ser sumamente exitoso, por ejemplo en el procesamiento de las imágenes sabemos que las capas convolucionales de una red neuronal son precisamente aquellas que satisfacen ser invariantes bajo las simetrías de la imagen que no toman en cuenta la posición de un objeto sino su forma.

Pensemos en un problema de detección de rostros como los que utiliza la policía por ejemplo, no importa dónde esté el rostro de una persona nos gustaría que el resultado de una red neuronal detecte correctamente su presencia.

La ecuación anterior representa la invarianza por traslación, Arq hace referencia la arquitectura de la red neuronal, Obj significa el objeto y Tr representa la traslación en el cuadro.

Large Language Models

Con el uso de los modelos del lenguaje como Word2Vec, BERT, ChatGPT, etc. es inminente preguntarnos si las arquitecturas que definen a estas funciones respetan la teoría del programa Erlanger, es decir si existen simetrías identificables dentro del modelo. Si Arq nuevamente significa la arquitectura de la red neuronal que predice por ejemplo el tópico, Txt representa un texto y Res denota la función de resumir un texto, ¿será esto cierto? No existen muchos trabajos sobre el tema sin embargo es una pregunta muy interesante.

Las arquitecturas de estos Larga Language Model están definidas por lo que conocemos como un Transformer y son sumamente interesantes misteriosas hasta la fecha.

Arbitraje y productos derivados

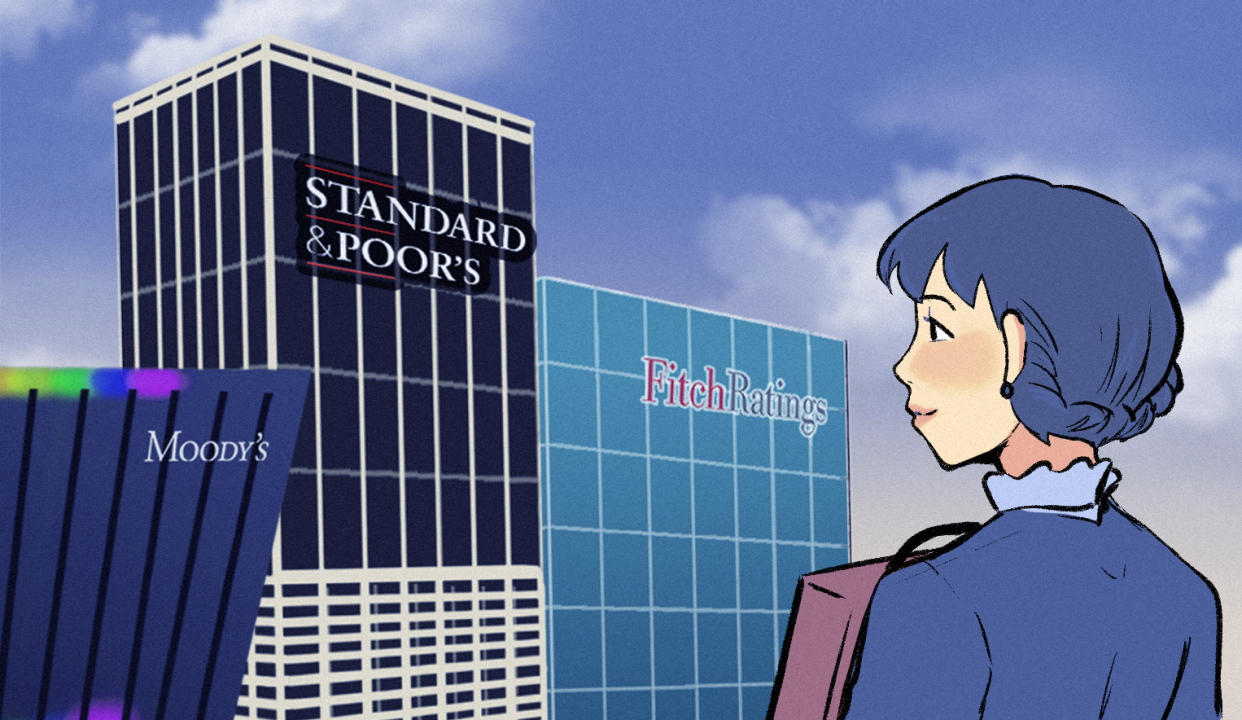

Un producto derivado es un objeto financiero que tiene una dependencia respecto a algún activo como las acciones de una empresa, una tasa de cambio o inclusive una criptomoneda. Por si mismos estos productos derivados podrían tener un valor para algún comprador y por lo tanto existe un gigantesco mercado donde estos productos derivados son intercambiados.

Uno de los logros más grandes de la Teoría Matemática Financiera es la capacidad de valuar con modelos muy certeros el precio de un producto derivado, uno de los trabajos más importantes es el de Black & Scholes pero existen otros también muy utilizados.

Como todo proceso de modelado matemático es fundamental fijar alguna creencia previa sobre nuestros datos o el fenómeno en general y una hipótesis que comúnmente se utiliza en el caso de los modelados de valuación de derivados es la llamada hipótesis de No Arbitraje.

El que no exista arbitraje significa que no existen oportunidades de comprar un activo en un mercado a un precio menor al que podría re-venderlo en alguno otro. Existen algunos estudios empíricos que sugieren que esta hipótesis no es descabellada.

Recientemente un equipo de la Oxford University ha construido una arquitectura de redes neuronales que permite introducir la hipótesis de no-arbitraje para modelar los precios de los derivados. Es fascinante imaginarse que esta arquitectura pueda estar relacionada con alguna simetría lo cual podría depender de una familia de conjuntos convexos definidos en este trabajo.

Oferta académica

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas)