Taleb, Pearl, Mumford y Chomsky: 4 ácidas críticas a Deep Learning

Las redes neuronales profundas son uno de los modelos más notables de machine learning para resolver distintas problemáticas, algunas relacionadas con la Inteligencia Artificial sin embargo su flexibilidad les ha permitido ser parte de otras soluciones menos sofisticadas.

Dentro de las principales razones por las cuales estos modelos son tan conocidos podríamos destacar dos, por un lado solucionan el dilema estadístico clásico sesgo-varianza y por el otro son modelos matemáticos versátiles para tratar distintas fuentes de información no-estructurada como imágenes, texto, audio, etc.

El status quo de la Inteligencia artificial prácticamente no podría entenderse sin su desarrollo y auge durante los últimos 30 años, cabe destacar el Premio Princesa de Asturias que recibieron hace algunos años los padres de Deep Learning.

En este texto vamos a presentarle a nuestra comunidad algunas desventajas que tienen las redes neuronales profundas para lograr reproducir una Inteligencia Artificial Avanzada. Estos argumentos han sido expuestos por notables científicos durante los últimos años.

Vale la pena mencionar que algunos de estos puntos como es natural, son sujetos a debate y no argumentamos ni a favor ni en contra, también nos concentramos en una parte concreta de estas críticas, los argumentos de todos ellos son mucho más elaborados y nos disculpamos por la simplificación. Al final les recomendaremos algunas fuentes originales para que conozcan la exposición completa.

Judea Pearl

Es uno de los científicos de la computación más prestigiosos, ha escrito numerosos libros que son referencia obligada para todos los interesados en la Inteligencia Artificial. Fue ganador del premio más importante para los científicos de la computación, el Turing Award.

Causalidad

Judea Pearl es el padre del estudio matemático de la causalidad, bien entendida la causalidad es la relación que existe entre dos variables X,Y. Como un ejemplo simple podríamos pensar en la variable Y como los malestares físicos y en X como la presencia de algún virus en el cuerpo de un ser humano. Diremos que Y es una causa de X cuando inclusive al perturbar la muestra de nuestra población o sus características, la presencia de X ocasiona la Y.

La crítica que hace Judea Pearl a las redes neuronales profundas es que en la mayor parte tanto de las investigaciones como del uso práctico de las redes neuronales, no es posible determinar una relación de causalidad en las acciones de estos modelos. Sin esta propiedad, Pearl invalida la posibilidad de utilizar redes neuronales para generar AI.

Noam Chomsky

Es un lingüista norteamerano cuyos trabajos son pioneros en el estudio moderno de esta área. Desde hace muchos años ha criticado severamente los acercamientos al procesamiento del lenguaje natural.

Normas Morales

Con el encumbramiento de Chat GPT como un modelo generativo de texto, la opinión de Chomsky era ampliamente esperada. Una de las críticas más ácidas a este tipo de intentos de IA es que su entrenamiento en grandes bases de datos está fundamentado en el plagio. Desde el punto de vista de Chomsky no existe una recompensa para estos modelos más allá del que tendría un modelo de autocompletado. Un enfoque muy distinto como el de los sistemas expertos sí permiten este tipo de adecuaciones.

Nassim Taleb

Es un matemático financiero que es conocido por sus ácidas críticas al acercamiento cuantitativo de los problemas financieros. Durante mucho tiempo trabajó como trader y analista de riesgos.

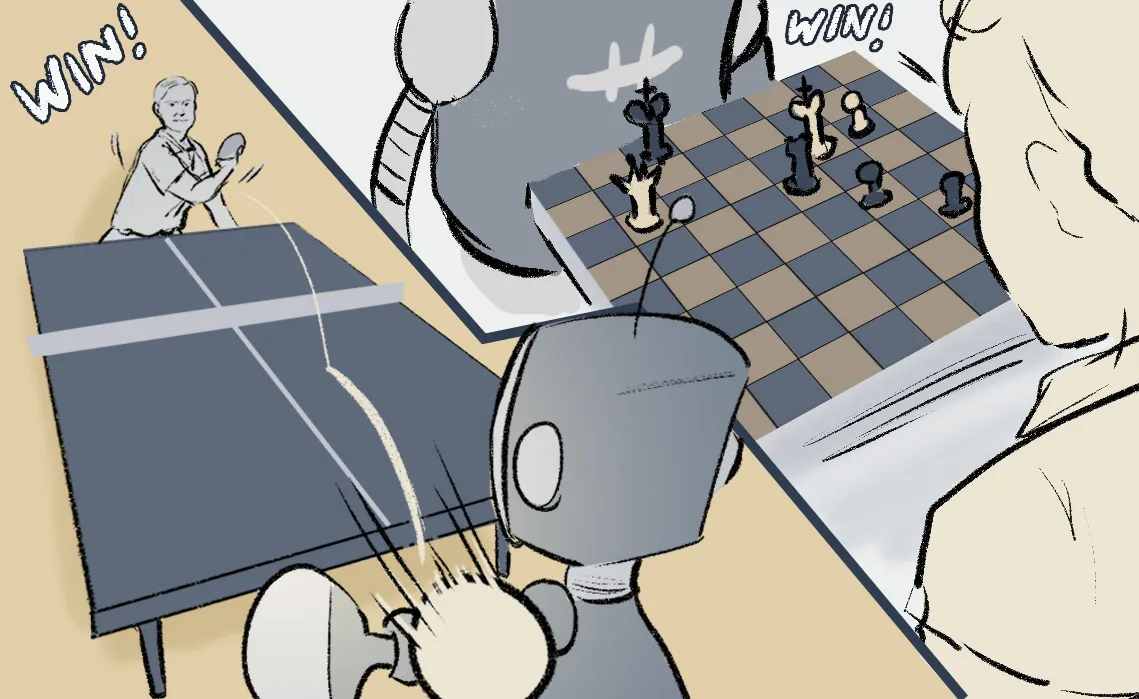

Eventos extremos

Aunque el estudio matemático de los hoy llamados cisnes negros no es obra única u originaria de Taleb, sus investigaciones en problemas concretos tanto financieros como médicos, económicos etc son esenciales para un análisis robusto que considere las distribuciones con colas gordas. Taleb argumenta que la naturaleza data driven de los modelos neuronales no considera eventos impredecibles gobernados por las distribuciones con largas desviaciones. Taleb acepta que existe una familia de problemas para los cuales es posible predecir, a estos les llama Mediocristan.

David Mumford

Es uno de los expertos históricos en el área de Geometría Algebraica, la cual estudia la relación que existe entre representaciones algebraicas y geométricas. Hace algunas décadas le puso una pausa a sus investigaciones en esta área y se dedicó a la Teoría de los Patrones iniciada por Grenander.

Teoría de patrones

Aunque la mayor parte de los ejemplos de AI investigados por Mumford están relacionados con el problema de la visión, tiene algunos trabajos en otras áreas. Respecto a los problemas del procesamiento de imágenes, Mumford critica a estos métodos como un sustituto de nuestra inteligencia natural pues no son capaces de construir un argumento que justifique sus predicciones, este problema de la explicabilidad de los modelos neuronales es sin lugar a dudas uno de los más críticos para su uso como AI.

¿Dónde aprender Deep Learning?

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).

Referencias originales