Taxonomía de las redes neuronales I: las capas

Las redes neuronales profundas son familias de funciones matemáticas maravillosas que permiten resolver problemas de Inteligencia Artificial mediante un acercamiento de Machine Learning. Dentro de sus ventajas más notables podemos destacar las siguientes:

- Aproximación universal: son lo suficientemente expresivas para reducir el error durante el entrenamiento tanto como sea necesario.

- Generalización: permiten realizar buenas predicciones fuera del conjunto de entrenamiento, inclusive cuando el conjunto no es monstruoso.

- Eficacia computacional: a pesar de involucrar billones de parámetros, estos modelos es posible entrenarlos en un tiempo razonable.

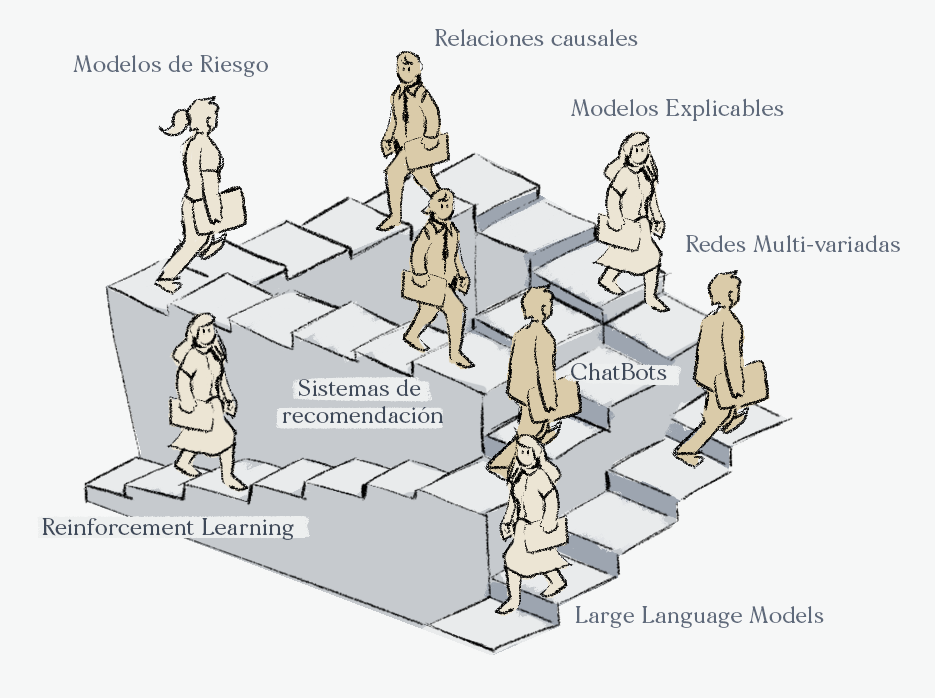

En este texto que hemos preparado para el Colegio de Matemáticas Bourbaki vamos a mencionar 4 sub-familias de las capas neuronales que son las más representativas y utilizadas en la actualidad.

Para simplificar la exposición no hablaremos sobre las distintas funciones de activación o arquitecturas sino simplemente hablaremos de una sola capa lo cual es suficiente para distinguir entre las densas, convolucionales, recurrentes y transformer.

Más adelante los invitamos a leer nuestros siguientes tres posts:

- Taxonomía de las redes neuronales II: las arquitecturas

- Taxonomía de las redes neuronales III: las funciones de error

- Taxonomía de las redes neuronales IV: las funciones de activación

Además de incluir las características de las funciones vamos a agregar algunos ejemplos de problemas que pueden resolverse con cada una de estas arquitecturas, es importante mencionar que en algunos casos existe más de una arquitectura con resultados competitivos para el mismo problema.

Capas neuronales densas

Las capas neuronales densas conectan a dos vectores mediante todas las posibles conexiones entre ellos, cada conexión tendrá un peso que el algoritmo de entrenamiento buscará modificar para reducir el error durante el proceso del entrenamiento.

¿Qué problemas resuelven comúnmente?

- Predicción de fraudes con datos transaccionales.

- Análisis de Churn.

- Análisis de sentimientos.

Capas neuronales recurrentes

Las capas neuronales recurrentes conectan dos registros de datos secuenciales, ingénuamente uno podría pensar que un vector es un registro secuencial sin embargo esto no es cierto. Los pesos de estas capas se anidan inductivamente formando un sistema dinámico entre las dos secuencias.

¿Qué problemas resuelven comúnmente?

- Valuación de activos financieros.

- Resúmenes de texto.

- Predicción de ventas.

Capas neuronales convolucionales

Las capas convolucionales conectan a dos tensores, a diferencia de las capas neuronales densas, las capas convolucionales no tienen tantos grados de libertad como parejas de coordenadas entre los dos tensores. Los parámetros forman únicamente un núcleo que viaja a través de los tensores y es constante a través de las distintas posiciones.

¿Qué problemas resuelven comúnmente?

- Detección de objetos en imágenes.

- Prevención del robo de identidad.

- Conducción de vehículos autónomos.

Capas neuronales de atención

Las capas atención conectan a dos vectores por medio de una operación conocida como el mecanismo de atención el asigna un peso que no depende únicamente de las dos coordenadas sino del resto de coordenadas en el vector de entrada.

¿Qué problemas resuelven comúnmente?

- Asistentes inteligentes como ChatGPT.

- Desdoblamiento de proteínas.

- Ecuaciones diferenciales parciales.

Oferta académica

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).